Nvidia Blackwell GPUの内部データフローと電力最適化技術を理解する

- Claude Paugh

- 2025年12月13日

- 読了時間: 7分

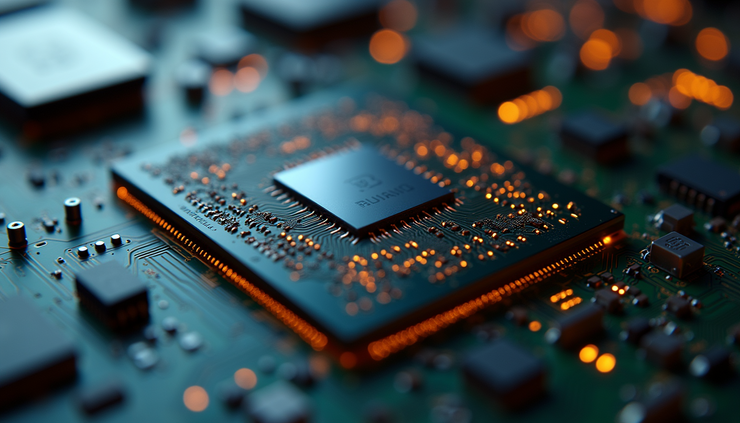

Nvidia Blackwell GPUは、グラフィックス処理技術における大きな進歩を象徴しています。その設計は、効率的なデータ移動、高速演算、そしてスマートな電力管理に重点を置いています。このGPU内部でのデータの流れを理解することで、現代のコンピューティング需要において重要な要素であるパフォーマンスとエネルギー効率をNvidiaがどのように両立させているかが分かります。

本記事では、Blackwell GPUの内部データフローを詳細に解説し、メモリとの間でのデータ転送方法、レジスタの役割、計算が行われる場所、そしてこれらのプロセスを支えるキャッシュ構造について解説します。また、速度を犠牲にすることなく消費電力を削減するためにNvidiaが採用している技術についても考察します。

メモリとGPU間のデータの移動方法

Blackwell GPUの動作の中核は、メモリシステムと処理ユニット間のデータ移動です。GPUは、速度と容量のバランスをとるために、マルチレベルのメモリ階層構造を採用しています。

グローバルメモリ(VRAM):これは最大かつ最も低速なメモリプールで、通常はGDDR6X以上です。テクスチャ、フレームバッファ、大規模なデータセットを保存します。

L2 キャッシュ:グローバル メモリと GPU コアの間に配置された L2 キャッシュは、頻繁にアクセスされるデータをコンピューティング ユニットの近くに保存することで、レイテンシを削減します。

共有メモリ / L1 キャッシュ:各ストリーミング マルチプロセッサ (SM) には、L1 キャッシュとして機能する、より小型で高速な共有メモリがあり、同じブロック内のスレッド間での高速なデータ共有を可能にします。

GPUはデータを必要とする際、まずL1キャッシュをチェックします。データが見つからない場合はL2キャッシュに移動し、必要に応じてグローバルメモリに移動します。この階層的なアプローチにより、低速なメモリアクセスを最小限に抑え、スループットを向上させます。

データ転送は、これらのメモリレベルを接続する高帯域幅の内部バスを介して行われます。Blackwellアーキテクチャは、データ要求のスケジュールと優先順位付けを行い、ボトルネックを軽減する高度なメモリコントローラを採用しています。また、非同期データ転送もサポートしているため、GPUは計算を継続しながらデータを取得できます。

データ処理におけるレジスタの役割

レジスタはGPUコア内部の最小かつ最速のストレージユニットです。GPU上で実行される各スレッドは、計算中の一時変数や中間結果を保持するための独自のレジスタセットを備えています。

高速アクセス:レジスタは、キャッシュやメモリよりもはるかに高速で、データへのほぼ瞬時のアクセスを提供します。

スレッド分離:各スレッドにはプライベート レジスタがあるため、データの競合を防ぎ、大規模な並列処理が可能になります。

サイズの制限:スレッドあたりのレジスタの数は制限されているため、低速の共有メモリやキャッシュにデータが溢れるのを避けるために、レジスタを効率的に使用することが重要です。

Blackwell GPUでは、Nvidiaはレジスタファイルの設計を改良し、容量の増加とアクセスレイテンシの低減を実現しました。これにより、より多くのデータが演算ユニットの近くに保持され、低速なメモリフェッチの必要性が軽減されます。

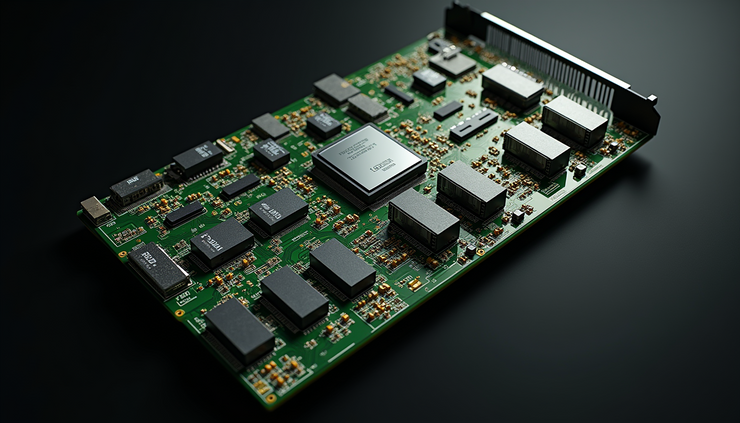

計算が行われる場所: ストリーミングマルチプロセッサとTensorコア

Nvidia Blackwell GPUは、主にストリーミングマルチプロセッサ(SM)で計算を実行します。各SMには、整数演算と浮動小数点演算を処理する複数のCUDAコアが搭載されています。これらのコアは数千のスレッドを並列実行することで、グラフィックスレンダリングや汎用コンピューティングにおいてGPUの効率性を高めています。

CUDA コア:標準的な算術演算と論理演算を処理します。

Tensor コア:行列計算用に設計された特殊なユニットで、AI および機械学習のワークロードを高速化します。

RT コア:レイ トレーシング計算専用で、リアルタイムの照明と影を改善します。

各SM内では、スケジューラがCUDAコアとテンソルコアに命令を分配します。結果はレジスタまたは共有メモリに一時的に保存され、その後キャッシュまたはグローバルメモリに書き戻されます。

データフローをサポートするキャッシュ構造

キャッシュはメモリレイテンシの削減とスループットの向上に重要な役割を果たします。Blackwell GPUには複数のキャッシュレイヤーが搭載されています。

L1キャッシュ/共有メモリ: SM内のスレッド間で共有される高速オンチップメモリ。スレッドが頻繁にアクセスまたは共有するデータを保存します。

L2キャッシュ: L1よりも容量が大きく、速度は遅く、すべてのSMで共有されます。グローバルメモリとSM間のバッファとして機能します。

テクスチャ キャッシュ:グラフィックス ワークロードで一般的な空間的局所性に合わせて最適化された、テクスチャ データ専用のキャッシュです。

これらのキャッシュは、低速なグローバルメモリアクセスの回数を削減します。NvidiaのBlackwellのキャッシュ設計には、最も有用なデータをコンピューティングユニットの近くに保持することを優先する適応型置換ポリシーも含まれています。

Blackwell GPU における電力最適化技術

現代のGPU、特にノートパソコンやデータセンターでは、電力効率が非常に重要です。Nvidia Blackwell GPUは、消費電力を削減するための複数の技術を採用しています。

ダイナミック電圧・周波数スケーリング(DVFS): GPUはワークロードの需要に応じてクロック速度と電圧を調整します。フルパワーが必要ない場合は、GPUの動作速度が低下し、消費電力も抑えられます。

きめ細かなパワー ゲーティング:使用されていない SM やテンソル コアなど、アイドル状態の GPU の一部は、電力を節約するために電源がオフになります。

効率的なデータ移動:メモリ レベル間のデータ転送を最小限に抑え、キャッシュを効果的に使用することで、GPU はメモリ アクセスに費やされるエネルギーを削減します。

最適化されたレジスタの使用:レジスタのスピルを削減し、データを高速レジスタに保持することで、電力を大量に消費するメモリ操作を削減します。

キャッシュのアダプティブ クロッキング:ワークロードが軽いときに電力を節約するために、キャッシュ速度を個別に調整できます。

これらの技術を組み合わせることで、消費電力を管理可能な範囲に抑えながら高いパフォーマンスを実現できます。例えば、AI推論タスクの実行中、Tensorコアはスループットを犠牲にすることなく、最適化された電力レベルで動作できます。

実例: リアルタイムレイトレーシングタスクにおけるデータフロー

大量の計算と高速なデータ アクセスを必要とするリアルタイム レイ トレーシング ワークロードを考えてみましょう。

データの読み込み:シーンのジオメトリとテクスチャは、グローバル メモリから L2 キャッシュに読み込まれます。

レイ トレーシング計算: RT コアは交差テストを実行し、CUDA コアはシェーディング計算を処理します。

中間結果:レジスタと共有メモリには、レイのヒット ポイントや照明値などの一時データが格納されます。

キャッシュ:頻繁にアクセスされるテクスチャはテクスチャ キャッシュに残り、シェーディングを高速化します。

電源管理:特定の SM が不要な場合は、パワー ゲーティングによってエネルギー使用量が削減され、DVFS はワークロードの強度に基づいてクロック速度を調整します。

このフローにより、最小限の遅延と制御された電力消費でスムーズなレンダリングが保証されます。

要点の要約

Nvidia Blackwell GPU は、マルチレベルのメモリ階層を使用してデータ アクセスを高速化します。

レジスタは、計算用の高速なスレッド固有のストレージを提供します。

ストリーミング マルチプロセッサと専用コアが計算の大部分を実行します。

キャッシュ構造により、低速のメモリアクセスが削減され、スループットが向上します。

DVFS やパワー ゲーティングなどの電力最適化技術は、パフォーマンスとエネルギー使用量のバランスをとるのに役立ちます。

これらの内部データフローと電力戦略を理解することで、NVIDIAがBlackwell GPUでエネルギーを効率的に管理しながら高いパフォーマンスを実現する仕組みを理解するのに役立ちます。開発者や愛好家にとって、この知識はソフトウェア設計とハードウェアの活用を向上させるのに役立ちます。